Некачественное планирование исследования и ошибки в анализе данных приводят к ложноположительным результатам. Несмотря на многолетние призывы к повышению качества научных работ, проблема низкопробных исследовательских методов актуальна и сегодня. Это наталкивает на мысль, что за ней стоит нечто большее, чем просто непонимание. Популярность низкопробных методов отчасти объясняется поощряющими их стимулами, которые ведут к естественному отбору «плохой науки». Этот процесс не связан с сознательными действиями учёных, с их ленью или желанием подтасовать результаты. Дело в том, что ключевое условие успеха в научной карьере — это публикации. Если рассматривать нормативные методы исследований, к которым прибегают учёные, можно с уверенностью предположить, что некоторые научные работы пишутся с расчётом на публикацию. В таких случаях качество самого исследования уходит на второй план. Уровень научной культуры не повысится до тех пор, пока не совершён переход от борьбы с неправильным пониманием к вознаграждению за правильное понимание. В данной работе мы приводим практические доказательства этого тезиса и даём ему логическое обоснование при помощи вычислительной модели. Сначала мы проведём мета-анализ статистической мощности исследований в области поведенческих наук за последние 60 лет и покажем, что качество исследований не повысилось, несмотря на постоянные призывы к этому. Чтобы продемонстрировать последствия, логически вытекающие из системных стимулов, мы представим динамическую модель научного сообщества, в которой конкурирующие лаборатории исследуют новые или уже опубликованные гипотезы при помощи культурно унаследованных методов. Как и в природе, самые успешные лаборатории производят больше «потомства», то есть используемые ими методы чаще копируются, а их выпускники чаще основывают свои лаборатории. Отбор по количеству публикаций приводит к деградации научных методов и чрезмерному увеличению числа ошибочных результатов. Кроме того, мы покажем, что повторные исследования замедляют процесс деградации, но не могут его остановить. Для того чтобы повысить качество исследований, нужно произвести изменения на институциональном уровне.

Чем больше количественные показатели общественного развития учитываются при решении социальных вопросов, тем чаще ими манипулируют и тем сильнее они искажают те социальные процессы, которые должны отражать. Дональд Кэмпбелл (1976, с. 49) [1].

Я присутствовал при работе нескольких отборочных комиссий. На моей памяти никто и никогда не просматривал чьи-либо работы. Единственное, что учитывалось, — количество и ИФ (импакт-фактор) публикаций. Терри Мак-Глинн (realscientists) (твит от 21 октября 2015 года, 16:42).

Введение

В марте 2016 года Американская статистическая ассоциация выпустила серию руководств по правильному и неправильному использованию p-значений [2]. Статистики публиковали подобные руководства на протяжении десятилетий [3, 4]. За современными схемами проведения исследований стоят годы выявления недостатков и периодического выпуска руководств с рекомендациями по их устранению, не говоря уже о стандартных проверках статистической значимости. И тем не менее в настоящее время количество исследований с неверными статистическими расчётами и некачественными методами не только не уменьшилось, но даже увеличилось. В таких областях, как психология, нейробиология и медицина, исследования с ложными результатами встречаются настолько часто, что считаются нормой [5-11].

Почему попытки исправить эту ситуацию постоянно заканчиваются провалом? В апреле 2015 года члены научно-исследовательской организации Великобритании приняли участие в закрытом симпозиуме на тему достоверности исследований в области биомедицины [12]. В центре внимания участников симпозиума оказался современный кризис доверия результатам исследований. Многие выдающиеся учёные выразили мнение, что около половины современных научных работ — не только в области медицины, но и в психологии и других областях — могут оказаться ошибочными [11, 13-15]. Количество фундаментальных ошибок в наиболее известных научных публикациях, а также их опровержений только растёт [16-18]. В отчёте об итогах симпозиума красной нитью проходит мысль, высказанная одним анонимным участником: «Плохие методы приносят больше результатов». Постоянные ошибки в методике проведения научного исследования рождаются не из простого непонимания, а, скорее, из-за определённых стимулов. Исправить эти ошибки можно только после того, как были устранены все факторы, побуждающие исследователей прибегать к низкопробным методам — руководства в этом отношении бессильны. Как сказал Ричард Хортон, редактор журнала The Lancet, «часть проблемы заключается в том, что никого не поощряют за то, что он прав» [12].

В данном исследовании мы попытаемся доказать, что современная наука активно поощряет и пропагандирует использование некачественных методов и побуждает учёных манипулировать статистическими расчётами. Мы назвали этот процесс естественным отбором «плохой науки», тем самым подчёркивая, что он происходит не по намерению исследователя или его желанию сфабриковать научные результаты, а из-за отбора тех научных методов и практик, которые с большей вероятностью приведут к публикации. Каким образом методы исследований могут подвергаться естественному отбору? Ведь никаких «генов» исследований не существует. Ответ заключается в том, что наука — это одна из областей культурной деятельности, которая развивается посредством именно эволюционных процессов [19-25]. Согласно таким философам науки, как Кэмпбелл [19], Поппер [26] и Халл [27], научные теории эволюционируют при помощи изменчивости и выборочного сохранения. Это утверждение справедливо и для научных методов. Лабораторные методы могут распространяться напрямую, через выпускников университетов, которые основывают собственные лаборатории, или же опосредованно, через перенятие методов у других, более успешных исследователей. Как правило, наибольшее распространение получают те методы, которые ассоциируются с бóльшим успехом в научной карьере.

Принципы естественного отбора живых организмов довольно просты. Чарлз Дарвин обозначил три условия, которые необходимы для естественного отбора:

- должна существовать изменчивость;

- изменчивость должна тем или иным образом влиять на выживание организма или его репродуктивную способность;

- приобретённые в результате изменчивости мутации должны наследоваться.

Если рассматривать исследования с этой точки зрения, то утверждать, что научные руководители передают какие-либо биологические признаки своим ученикам, было бы неразумно. Однако нельзя отрицать тот факт, что исследовательские методы всё-таки меняются. Изменчивость влечёт за собой определённые последствия: методы, которые чаще приводят к публикации, приобретают конкурентное преимущество над остальными. При этом можно сказать, что «мутации» в методике частично наследуются, так как студенты перенимают устоявшуюся практику и статистические методы у своих преподавателей и однокурсников. Учёные также могут перенимать успешные модели исследований у коллег в своей области, даже если не знают их лично. Таким образом, поощрение только за опубликованные работы ведёт к естественному отбору тех исследовательских методов, которые с большей вероятностью приведут к публикации. К сожалению, подобные критерии отбора могут напрямую препятствовать научному прогрессу.

Высказанная выше идея совсем не нова. В данной работе мы не просто постулируем идею, а пытаемся дать ей теоретическое и практическое обоснование. Сначала мы приведём доказательства того, что институциональные стимулы увеличивают количество ложноположительных результатов. Затем мы представим обзор научной литературы, призывающей к повышению качества исследовательских методов, с упором на хорошо известную и понятную всем проблему статистической мощности. Мы покажем, что несмотря на то, что за последние 50 лет обозреватели научной литературы не раз обращали внимание на низкую статистическую мощность исследований и предсказывали её последствия, качество науки практически не изменилось.

Практические доказательства могут выглядеть убедительно, но их недостаточно. Не следует забывать о том, что выдвинутый нами тезис должен быть логически обоснован — поэтому мы также проанализируем его формальную модель. Теоретический анализ тезиса об отборе «плохой науки» преследует две цели: во-первых, если тезис окажется нерабочим в теории, то его нельзя использовать в качестве объяснения, о чём бы ни говорили эмпирические данные; во-вторых, формализация тезиса добавит ему ясности и позволит анализировать и разрабатывать вмешательства. Для иллюстрации тезиса мы введём динамическую модель поведения популяции, состоящую из конкурирующих субъектов. При этом мы отталкиваемся от предположения, что все субъекты абсолютно честны и не стремятся подделывать результаты исследований. Научные методы изменяются и развиваются в зависимости от того, привели ли они к публикации и, как следствие, найму на работу или продлению пребывания исследователя в своей должности. Таким образом, наш тезис можно отнести даже к тем учёным, которые не испытывают прямое воздействие стимулов, побуждающих прибегать к некачественным методам. В результате мы покажем, что причина, по которой проблема некачественных исследований сохраняет актуальность такое долгое время, связана с тем, что «плохая наука» — это результат естественного отбора.

Институциональные стимулы для научных исследователей

На протяжении последних десятилетий количество научных публикаций неуклонно возрастает [28, 29]. Отчасти это связано с расширением возможностей для сотрудничества и увеличением числа работ, написанных несколькими авторами [30, 31]. Однако причина может заключаться и в меняющихся карьерных стимулах. В одном из недавних исследований биологи Бришу и Анжелье [32] изучили карьерную статистику младших исследователей, принятых в отдел эволюционной биологии Национального центра научных исследований Франции в промежуток с 2005 по 2013 год. Согласно результатам этого исследования, среднее количество публикаций неизменно возрастает в период принятия очередного сотрудника на работу. В настоящее время новоприбывшие биологи выпускают в два раза больше публикаций по сравнению с тем, что было 10 лет назад (22 в 2013-м и 12,5 в 2005-м). Эти числа отражают ужесточение конкуренции в борьбе за место в научных исследовательских учреждениях. Мировые университеты выпускают гораздо больше докторов наук, чем имеется постоянных вакансий [33-35], и хотя эта проблема стала особенно острой только в последние годы, зародилась она как минимум два десятилетия назад [36]. В этой ситуации тяжелее всего приходится выпускникам не самых престижных университетов, которые сталкиваются с дополнительной дискриминацией на рынке труда [37]. Несмотря на то, что за пределами научной сферы могут быть гораздо более высокооплачиваемые вакансии, преподавательские должности в крупнейших исследовательских университетах остаются предпочтительным выбором, поскольку они престижны и предоставляют свободу творчества и исследований. Среди тех, кто смог получить подобную должность, продолжается конкуренция за гранты, продвижение по службе, престиж и устройство выпускников.

Конкуренция стимулирует учёных выделяться на фоне своих коллег. Только самые лучшие студенты могут получить преподавательскую должность, и только лучшие младшие преподаватели могут получить постоянную должность профессора и крупные гранты. Не так давно лауреат Нобелевской премии физик Питер Хиггс, в 1960-х годах ставший одним из основоположников теории фундаментальных частиц, высказал своё сожаление по поводу сложившейся ситуации: «Сейчас я бы попросту не смог получить свою работу. Я думаю, что меня посчитали бы недостаточно продуктивным» (The Guardian, 06.12.2013). Безусловно, это заявление довольно спорно: молодой Питер Хиггс наверняка смог бы получить работу и сегодня. Однако его карьера могла бы сложиться не очень успешно. Практика показывает, что львиная доля опубликованных исследований c высокой цитируемостью принадлежит небольшому количеству учёных, от которых зависит открытие новых лабораторий и получение докторских степеней. Кроме того, бóльшую часть новых преподавательских должностей занимают выпускники немногочисленных элитных университетов, у которых, как правило, очень много публикаций [37].

Один из способов выделиться на общем фоне — это утверждение революционности своего исследования. И действительно, количество новаторских работ в последнее время зашкаливает — или работ, которые, по крайней мере, претендуют на новаторство. За период с 1974 по 2014 год частота употребления слов «инновационный», «революционный» и «новаторский» в исследованиях, размещённых в электронном архиве PubMed, увеличилась на 2500% или даже больше [39]. Поскольку вероятность того, что отдельные научные публикации действительно стали в 25 раз более новаторскими за последние 40 лет, крайне мала, можно сделать вывод, что эволюция языка написания работ вызвана возросшим давлением на исследователей в отношении новизны и выделения себя из толпы.

Ещё один способ выделиться на фоне коллег состоит в простом увеличении количества выпускаемых работ. По неофициальным сведениям, именно количество публикаций является определяющим критерием, которым руководствуется отборочная комиссия при принятии решений. Помимо количества работ, оценивается их влиятельность: некоторые исследователи уделяют большое внимание h-индексу, который равен h, если автор имеет h публикаций, каждая из которых цитируется как минимум h раз [40]. Однако зачастую исследовательские качества оцениваются только на основании объёма публикаций — особенно это касается начинающих исследователей, которые не успели набрать большого числа цитирований. Степень влияния объёма публикаций на оценку исследователя — так же как и представление о продуктивности, которую он должен продемонстрировать, — разнится в зависимости от области исследований. Выдвигаемый нами тезис относится ко всем научным областям, где успешность учёного определяется именно количеством публикаций.

Каждый раз, когда для оценки социального поведения используются количественные критерии, возникает опасность манипулирования данными и их искажения [1, 41, 42]. Как говорится, «когда метод становится самоцелью, он перестаёт быть хорошим методом». К примеру, с тех пор как был принят h-индекс, исследователи начали искусственно раздувать свои индексы посредством самоцитирования [43] и даже прибегать к умным способам «полумошенничества». В качестве иллюстрации того, как можно обмануть систему h-индексов, можно привести эксперимент, в котором учёные написали шесть ненастоящих работ под именем вымышленного автора, содержащих много ссылок на их собственные исследования [44]. Эти работы были опубликованы на сервере одного из университетов. После их индексации в Google выяснилось, что h-индексы работ исследователей в «Академии Google» резко выросли. Хотя подобные стратегии, направленные на манипулирование количественными показателями, создаются только в целях мошенничества, они влекут за собой гораздо более значительные последствия1.

Наш тезис заключается в том, что погоня за длинным списком опубликованных работ оказывает особое влияние на экологию научного сообщества. Эта проблема частично связана с тем, что положительные результаты, подтверждающие новаторскую гипотезу, публикуются гораздо чаще, чем отрицательные результаты, особенно в наиболее влиятельных журналах. К примеру, вплоть до недавнего времени редакторы Journal of Personality and Social Psychology отказывались публиковать неудавшиеся попытки воспроизведения ранее опубликованных в журнале новаторских исследований [45]. Многие исследователи, которым не удалось добиться признания своих гипотез, даже не пытаются опубликовать результаты своих изысканий [46]. Ситуация, в которой учёных побуждают получать положительные результаты, чаще всего приводит к всплеску ошибочных исследований.

Если учёных награждают только за публикации, а исследования с положительными результатами чаще появляются на страницах журналов и ценятся выше остальных, преимущество получают те исследователи, которые могут получить больше положительных результатов любой ценой. В этой связи неудивительно, что учёные иногда предпочитают не сообщать о гипотезах, которые не дали положительных результатов (подобные неудачи закрывают путь к публикации) [47], даже несмотря на то, что это могло бы предотвратить публикацию ложноположительных результатов в будущем [11]. Для того, чтобы получить положительные результаты, которые с большой степенью вероятности описывают истинный эффект, можно улучшить теоретическое обоснование гипотезы и тщательнее проследить за правильностью проведения эксперимента [15]. Недостаток этого способа в том, что он требует больших усилий и наверняка понижает продуктивность исследователя. Альтернативный вариант — это намеренное или ненамеренное использование методов, которые позволяют увеличить количество ложноположительных результатов. Подобные методы обладают двойным преимуществом: во-первых, они позволяют получить бóльшие объёмы результатов по сравнению с более тщательными способами проведения исследования, а во-вторых, они чаще приводят к публикации. И хотя время от времени некачественные исследования с невоспроизводимыми результатами опровергаются, это скорее исключение, чем правило [48]. К примеру, было подсчитано, что повторные исследования [49] проводились в отношении только 1% от всех опубликованных гипотез в области психологии, причём неудавшиеся попытки воспроизведения результатов зачастую оспариваются [50-52]. Более того, даже полностью опровергнутые исследования часто продолжают цитироваться учёными, которые не знают об опровержении [53]. Таким образом, с момента опубликования статья с ошибочными результатами оказывает постоянное влияние на критерии, используемые для оценки исследователей, которые и являются авторами выполненной работы.

Ошибочные научные результаты могут быть следствием мошенничества или манипуляций с p-значениями [54], однако во многих случаях авторами таких работ становятся абсолютно добросовестные исследователи. Ошибки легко заметить, когда результаты исследования абсурдны — к примеру, некоторые учёные, пользуясь традиционными для своей области методами, пришли к выводу, что нервная система мёртвого атлантического лосося откликается на эмоциональные стимулы [55]. Также в пример можно привести исследование, согласно которому учащиеся университетов обладают способностями к предвидению и могут предсказывать результаты случайного генератора чисел [56]. Однако чаще всего распознать ошибочные результаты с первого взгляда невозможно — в этом и заключается проблема. Иногда некачественные или недопустимые теории строятся на гипотезах, которые были выбраны практически случайно, что существенно снижает вероятность того, что положительный результат будет описывать истинный эффект [13, 15, 57]. Ложноположительные результаты также могут быть следствием повторной интерпретации исследования после получения результатов, когда учёный отбирает только те статистические данные, которые подтверждают гипотезу [58] или же формулирует саму гипотезу постфактум [8].

Закон Кэмпбелла, приведённый в эпиграфе к данной работе, означает, что стимулы к увеличению количества публикаций побуждают учёных изменять свои методы, чтобы получать как можно больше результатов, которые могут быть напечатаны, вместо того, чтобы заниматься более тщательными исследованиями. Мы предполагаем, что это приводит к эволюционному отбору низкопробных методов, когда качество исследований приносится в жертву объёму публикаций. При этом важно понимать, что данный процесс не зависит от намерения человека. Если провести аналогию с биологической эволюцией, шеи жирафов постепенно удлинялись не потому, что отдельные животные вытягивали свои шеи, а потому, что более длинные шеи позволяют получать больше пищевых ресурсов и, соответственно, производить больше потомства. Аналогичным образом, общепринятые исследовательские методы в научных сообществах могут постепенно меняться не только по намерению наиболее влиятельных учёных, но и потому, что некоторые из исследователей более успешно передают методы новому поколению, чем другие. Карьерные стимулы оказывают влияние как на направление развития науки, так и на сам процесс отбора. Важно отметить, что распространённость стратегических инноваций в методике и скорость их распространения в научном сообществе никак не связаны между собой.

Практический анализ: статистическая мощность не увеличилась

В качестве примера рассмотрим необходимость повышения статистической мощности. Статистическая мощность — это вероятность отвержения неверной нулевой гипотезы при проверке статистических гипотез, зависящая от размера выборки, величины эффекта и вероятности ложноположительного результата2 [59]. Поскольку многие эффекты в биомедицине, поведенческих науках и социологии малы [60-62], исследования должны обладать достаточно большой статистической мощностью. С другой стороны, эксперименты с низкой статистической мощностью легче проводить при изучении людей и других млекопитающих, особенно в тех случаях, когда общая выборка мала, эксперимент требует дорогостоящего оборудования или сбора данных в течение продолжительного времени. Очевидно, исследования с низкой статистической мощностью чаще приводят к ложноотрицательным результатам. Менее очевидным представляется тот факт, что низкая статистическая мощность может повысить вероятность получения ошибочных результатов и завышения величины эффекта из-за плохого отсеивания случайного шума [13, 63, 64].

В самой сути статистической мощности заложено противоречие. В идеальном научном сообществе с развитым взаимодействием, которое стимулирует исследователей находить модели, достоверно объясняющие ход вещей, повышение статистической мощности приносит только пользу. Даже в таких благоприятных условиях достигнуть идеальной мощности невозможно, но и поддерживать мощность на низком уровне нет никакого смысла. Однако в реальном научном сообществе, где публикаций и наград удостаиваются только исследования с положительными результатами, более эффективным решением станет проведение исследований с низкой статистической мощностью. Почему? Подобные исследования дёшевы и приносят значительные результаты, особенно в тех случаях, когда гипотеза относится только к отсутствию или наличию какого-либо эффекта и не включает в себя конкретные количественные характеристики и тенденции [3]. Низкая статистическая мощность позволяет исследователям нарастить объём публикаций за счёт увеличения риска наводнить научную литературу ошибочными данными — более подробно мы опишем и проиллюстрируем эту точку зрения в одном из последующих разделов. В настоящее время между обществом в целом и отдельными учёными существует интуитивно понятный конфликт интересов, связанный со статистической мощностью. Общество получает от высокой статистической мощности больше выгоды, чем отдельные исследователи. В науке нет своей «невидимой руки», благодаря которой собственные интересы индивидов в обязательном порядке приносили бы коллективную выгоду.

Учёные уже давно признали существование этого конфликта интересов. Первый наиболее известный и часто цитируемый призыв к увеличению статистической мощности исследований принадлежит Джейкобу Коэну. Его публикация в 1962 году была вызвана тревогой по поводу снизившейся статистической мощности проводившихся в то время исследований в области психологии [65]. Ответ или отсутствие ответа на столь часто цитируемый призыв служит первым индикатором того, у какой стороны конфликта есть преимущество. Чуть меньше чем через два десятилетия после появления призыва Коэна Седлмайер и Гигеренцер [66], а также Росси [67] опубликовали два мета-анализа, в которых было изучено в общей сложности 25 обзоров статистической мощности психологической и социологической литературы, опубликованной в период с 1960 по 1984 год. В результате выяснилось, что статистическая мощность работ в этих областях была довольно низкой и, что более важно, за прошедшие с момента призыва Коэна [65] годы не наметилось никакой тенденции к её увеличению. Согласно недавнему исследованию Ванкова и соавторов [68], статистическая мощность психологических исследований остаётся низкой вплоть до сегодняшнего времени.

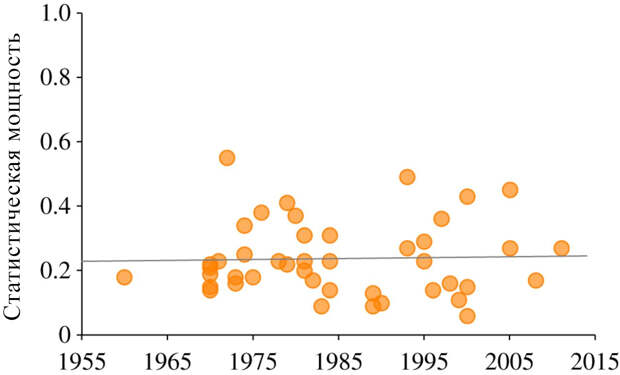

Мы решили продолжить анализ этой проблемы и сделали поисковый запрос в «Академии Google» по ключевым словам «статистическая мощность» и «обзор», ограничив круг поиска работами, в которых имеются ссылки на мета-анализ Седлмайера и Гигеренцера [66] (наиболее часто цитируемый из двух упомянутых выше мета-анализов). Мы нашли все работы с обзорами статистической мощности публикаций в области социологии, поведенческих наук и биологии — всего 19 исследований в 16 работах, опубликованных в промежуток с 1992-го по 2014 год. Более подробная информация об использованных нами методах и источниках дана в приложении. Мы ориентировались на статистическую мощность с малой величиной эффекта порядка d = 0,2, которая наиболее часто встречается в социологических исследованиях. Полученные нами данные, а также данные из мета-анализов Седлмайера, Гигеренцера [66] и Росси [67] представлены на рисунке 1. Среднее значение статистической мощности довольно низкое — всего 0,24, что означает, что слабые эффекты могут быть не выявлены в ходе проверок в трёх из четырёх случаев. Что ещё более важно, статистическая мощность не проявляет никаких признаков роста уже на протяжении шести десятилетий (R2 = 0,00097). Эти сведения не могут дать полной картины происходящего в какой-либо области социологии или поведенческих наук, однако могут объяснить, почему ошибочные результаты встречаются настолько часто. Более того, мы могли переоценить величину статистической мощности, так как исследовали только опубликованные материалы, которые должны обладать некоторым минимальным значением мощности для того, чтобы пройти экспертную оценку, направленную на выявление ненулевого эффекта3.

Рисунок 1. Средняя статистическая мощность на основании 44 обзоров научных работ в области социологии и поведенческих наук, опубликованных в период с 1960 по 2011 год. Данные позволяют выявить малую величину эффекта (d = 0,2) при доле ложноположительных исследований α = 0,05, а также демонстрируют, что статистическая мощность крайне мала (среднее = 0,24) и не увеличилась со временем (R2 = 0,00097).

Почему такой заметный и всеми признанный недостаток исследования, как низкая статистическая мощность, существует так долго? Есть два возможных ответа на этот вопрос. Во-первых, исследователи могут непосредственно откликаться на стимулы и рассматривать неверные методы как способ достижения успеха в карьере. К примеру, анализируя феномен продолжительного существования статистической мощности низкого уровня, Ванков и соавторы [68] предполагают следующее: «Учёные — обычные люди, отвечающие (сознательно или бессознательно) на стимулы. Если личный успех (продвижение по карьерной лестнице) ассоциируется с качеством и, что более важно, количеством публикаций, то исследователь посчитает целесообразным сэкономить свои умственные ресурсы, чтобы выпустить как можно больше публикаций» (с. 1037, выделено в оригинальном тексте). Во-вторых, даже если учёные крайне тщательно подходят к выполнению исследования, бездумный подход и неверные методы могут поощряться критериями отбора. В таком случае конкурентное преимущество получат те методы, которые позволяют достичь большего числа научных целей, а все альтернативные методы будут вытеснены с рынка труда и страниц научных журналов. Ванков доказывает это на примере психологии, в которой широко распространены ложные трактовки статистической мощности и других статистических понятий. Все эти трактовки существуют с одной целью — они делают более вероятным получение положительных результатов исследования, будь они истинными или ложными. При этом случаи, когда ложная трактовка негативно сказывалась бы на карьере исследователя, встречаются очень редко.

В реальности наверняка встречаются оба эти объяснения, причём для некоторых учёных или сообществ более характерно одно объяснение, чем другое. Наша рабочая гипотеза заключается в том, что большинство исследователей придерживаются принципа честного проведения исследований и стараются найти достоверные объяснения изучаемым феноменам. Однако имеющихся у нас данных недостаточно. Сведения, на основе которых строятся эволюционные и исторические исследования, дают мало возможностей для анализа динамических процессов [70], особенно тогда, когда данных в принципе мало — например, в области научной методологии. Перед тем как провести полноценное исследование на основе подобной динамической популяционной гипотезы, обратимся к её подробному теоретическому описанию.

Эволюционная модель науки

Для того чтобы обосновать логику естественного отбора «плохой науки», мы разработали и проанализировали динамическую популяционную модель. Эта модель одновременно проверяет логичность гипотезы и раскрывает её возможные следствия, что упрощает процесс опровержения [71, 72]. Разработанная нами модель воспроизводит эволюционный процесс: учёные соревнуются между собой за престиж и карьеру, при этом критерием отбора кандидата является количество публикаций. Более успешные лаборатории получают большее количество учеников, которые наследуют их методику.

В качестве основы мы взяли ранее опубликованную математическую модель [15], в которой учёные исследуют новые и уже проверенные гипотезы и пытаются обнародовать свои результаты посредством публикаций. Различия в качестве исследований, доле повторных исследований и систематических ошибках, связанных с предпочтительной публикацией положительных результатов, представлены с точки зрения динамики. Данная модель была решена алгебраически для конкретных значений вероятности того, что заданная гипотеза верна, на основании любых найденных публикаций.

В данной работе мы расширили эту модель, сделав упор на ограниченную гетерогенную совокупность N лабораторий. Мы предполагаем следующее:

- Каждая лаборатория обладает собственной мощностью, то есть способностью идентифицировать верные гипотезы. Величина мощности зависит не cтолько от качества статистических методов, сколько от качества процесса исследования в целом.

- Повышение мощности приводит к увеличению доли ложноположительных результатов, за исключением случаев, когда проводится их проверка, и объём работ в рамках исследования увеличивается.

- Проведение проверки замедляет процесс исследования, что снижает продуктивность лаборатории.

Важно понимать, по какой причине повышение мощности приводит к увеличению доли ложноположительных результатов, при условии, что объём работ и качество исследований остаются прежними. Способ повышения мощности на самом деле довольно прост: чтобы не ошибиться, посчитав верную гипотезу ложной, достаточно подтверждать все предложенные гипотезы. Из такого подхода очевидно следует, что количество ложноположительных результатов возрастёт. Для того чтобы справиться с этой проблемой, можно повысить требования к доказательствам гипотез, однако это приведёт к снижению мощности, поскольку даже истинные эффекты иногда дают слабые сигналы или шум — по крайней мере, до тех пор, пока исследователь не решит провести дополнительную проверку, увеличив размер и качество выборки. Это логическое следствие теории обнаружения сигнала [73].

Существуют и другие способы нахождения баланса между эффективностью лаборатории и качеством исследований. К примеру, порог различимости сигнала от шума можно отнести к характеристикам лаборатории — это позволит максимально приблизиться к модели обнаружения сигнала. Иными словами, мы выдвигаем поведенческую гипотезу, согласно которой учёные проводят исследование с предубеждением, что выдвинутая гипотеза верна, и выбирают те методы, которые скорее приведут к подтверждению истинности эффекта. В результате эффективность лаборатории повышается или сохраняется на прежнем уровне, несмотря на то, что номинальная статистическая мощность остаётся низкой. Однако в то же время это приведёт к более частому получению ложноположительных результатов, поскольку многие гипотезы на самом деле неверны. Формально любой из двух предложенных выше вариантов можно трансформировать в другой, однако в основе каждого из них заложены разные гипотезы о поведении человека, из которых логически вытекают разные методы. Проблема баланса между эффективностью и качеством исследований обсуждалась и в менее строгой с научной точки зрения литературе [64, с. 288].

Итак, лаборатории изначально обладают определёнными характеристиками, проводят эксперименты и отправляют на публикацию результаты. Однако положительные результаты публикуются чаще отрицательных. Кроме того, авторы получают вознаграждения за публикации (престижем, грантами или большими возможностями для выпускников), а самые продуктивные лаборатории получают больше шансов на распространение своих методов благодаря выпускникам, которые основывают новые лаборатории, во многом напоминающие «родительские», но не идентичные им.

В предложенной нами модели можно выделить две стадии: наука и эволюция. На научной стадии каждая лаборатория имеет возможность выбирать гипотезы, экспериментально исследовать их и представлять результаты на всеобщее рассмотрение посредством рецензируемых публикаций. Гипотезы изначально рассматриваются как однозначно верные или ложные, хотя их эпистемологический статус остаётся неизвестным вплоть до проведения экспериментов. На эволюционной стадии действующая лаборатория может «погибнуть» (прекратить исследования), освободив путь новым лабораториям, использующим методы «родителей». Чем успешнее лаборатория, тем больше шансов оставить «потомство».

Наука

Научная стадия делится на три фазы: выбор гипотезы, исследование и рассмотрение. В каждый временной отрезок каждая лаборатория i случайным образом начинает новое исследование с вероятностью h(ei), где ei определяет работу, выполняемую лабораторией для повышения качества своих экспериментальных и статистических методов. Чем больше объём этой работы, тем качественнее становятся методы (в частности, это позволяет увеличить мощность за счёт уменьшения доли ложноположительных результатов) и тем дольше длится процесс проведения и анализа экспериментов4. Вероятность принятия на рассмотрение новой гипотезы в заданный временной отрезок рассчитывается следующим образом:

h(ei) = 1 − ηlog10ei,

где η — это постоянная, показывающая, насколько улучшение качества методов снижает частоту исследований в лаборатории. В целях упрощения ei ограничивается интервалом от 1 до 100 для всех лабораторий. Во всех наших симуляциях η = 0,2, чтобы значение h было неотрицательным. Это значение достаточно занижено: в большинстве проведённых нами симуляций лаборатории изначально имели довольно высокую частоту исследований h = 0,63 при самом высоком качестве используемых методов. Тем не менее полученные нами результаты подходят для любой монотонно убывающей неотрицательной функции h(ei).

Экспериментальное исследование начинается с выбора гипотезы. Вероятность того, что эта гипотеза уже была хотя бы единожды подтверждена в опубликованной литературе, обозначается как ri — в таком случае мы имеем дело с повторным исследованием. Как вариант, лаборатория может выбрать для исследования новую, непроверенную, или по крайней мере неопубликованную гипотезу. Новая гипотеза верна с вероятностью b, которая имеет своё постоянное значение для каждой научной области. В настоящее время точный расчёт этого значения невозможен: в некоторых областях оно может достигать 0,1, а в других — гораздо меньшей величины [13-15].

Каждая лаборатория характеризуется своим собственным подходом к исследованию. У каждой лаборатории i есть собственная мощность Wi, связанная с методикой и определяющая вероятность выявления верной гипотезы Pr(+|T). Снова отметим, что мощность характеризует не только статистические методы, а весь процесс исследования. Значение мощности может быть очень большим даже при маленькой выборке. Доля ложноположительных результатов αi представляет собой выпуклую функцию от мощности. Мы предполагаем, что эта функция зависит не только от мощности, но и от тщательности исследования и качества используемых в лаборатории методов:

αi = Wi/(1 + (1 — Wi)ei)

Соответствующее отношение показано на рисунке 2. Данная функциональная зависимость отражает вытекающий из теории обнаружения сигнала компромисс: для того чтобы определить все верные гипотезы, необходимо посчитать все гипотезы верными. Аналогичным образом для того, чтобы не допустить признания ни одной ложной гипотезы верной, придётся посчитать все гипотезы ложными. Следует отметить, что доля ошибок — то есть положительных результатов, которые оказались ложноположительными, — определяется не только собственно долей ложноположительных результатов, но и постоянным значением b. Верные гипотезы встречаются реже, чем ложные [13, 15].

Рисунок 2. Отношение между мощностью и долей ложноположительных результатов с учётом качества исследований e. Симуляции, анализируемые в данной работе, были проведены с заданным значением e0 = 75 (оранжевая кривая), при условии что α = 0,05 при мощности 0,8.

Особенность нашего функционального подхода заключается в том, что повышение качества исследований не приводит к увеличению мощности — в нашей модели эти переменные не зависят друг от друга. Это не характерно для классической теории обнаружения сигнала. Уменьшение шума посредством увеличения тщательности проведения экспериментов влияет на долю как верных, так и ложноположительных результатов. Однако такой подход вполне оправдан, если отталкиваться от предположения, что мощность поддерживается методами, которые выбираются в зависимости от природы доказательств [58]. В то же время, если отрицать это предположение и считать изначально присущие исследователю методы постоянными, независимость качества исследований и мощности лучше рассматривать как удобную для изложения формулировку следующей идеи: качество исследования — это сумма всех методологических особенностей, которые позволяют повысить мощность без увеличения доли ложноположительных результатов.

Все исследования приводят к положительным или отрицательным результатам: верная гипотеза приводит к положительному результату с вероятностью Wi, а ложная — с вероятностью αi. После получения результатов лаборатория отправляет их в журнал для рассмотрения и публикации. Мы предполагаем, что положительные результаты новых исследований публикуются всегда, в то время как отрицательные — никогда. Положительные и отрицательные результаты повторных исследований публикуются реже. Наше предположение приблизительно соответствует распространённым критериям публикации. Повторные исследования с положительными и отрицательными результатами публикуются с вероятностями cR+ и cR− соответственно.

Рассмотренные результаты исследований публикуются, за что лаборатории получают награды — будь то престиж, влияние или спонсирование, — которые способствуют распространению методов, приведших к успеху. За время существования лаборатории награды накапливаются. Их количество зависит от типа исследования: новаторские гипотезы ценятся больше воспроизведённых из других работ экспериментов. Награды также могут накапливаться в том случае, когда оригинальное лабораторное исследование пытаются воспроизвести другие учёные. Если повторное исследование дало положительные результаты, лаборатории получают поощрение, в обратном случае — штрафы. Значения наград и других параметров указаны в таблице 1.

Таблица 1. Основные параметры модели.

| Параметр | Определения | Использованные значения |

| N | Количество лабораторий | 100 |

| r0 | Начальная доля повторных исследований для всех лабораторий | {0, 0,01; 0,2; 0,5} |

| e0 | Начальное качество исследований для всех лабораторий | 75 |

| W0 | Начальная мощность для всех лабораторий | {0, 0,01; 0,2; 0,5} |

| η | Влияние качества на продуктивность | 0,2 |

| cR+ | Вероятность публикации повторного исследования с положительным результатом | 1 |

| cR− | Вероятность публикации повторного исследования с отрицательным результатом | 1 |

| VN | Награда за публикацию нового исследования | 1 |

| VR+ | Награда за публикацию повторного исследования с положительным результатом | 0,5 |

| VR− | Награда за публикацию повторного исследования с отрицательным результатом | 0,5 |

| V0+ | Награда за успешное воспроизведение нового исследования | 0,1 |

| V0− | Штраф за неудавшееся воспроизведение нового исследования | −100 |

| d | Величина выборки исследования, проанализированных с момента формирования до исчезновения | 10 |

| μr | Вероятность мутации r | {0; 0,01} |

| μe | Вероятность мутации e | {0; 0,01} |

| μw | Вероятность мутации w | {0; 0,01} |

| σr | Стандартное отклонение от величины мутации r | 0,01 |

| σe | Стандартное отклонение от величины мутации e | 1 |

| σw | Стандартное отклонение от величины мутации w | 0,01 |

Эволюция

В конце каждого временного отрезка, когда лаборатория исчерпала все возможности к проведению исследований и их публикации, наступает стадия отбора и воспроизведения. Сначала одной лаборатории суждено «погибнуть». В случайной выборке из d лабораторий исчезает самая старая, то есть «выживаемость» лаборатории часто, хоть и не всегда, зависит от возраста. Если в выборке оказалось несколько лабораторий одного возраста, одна из них выбирается случайным образом, после чего удаляется из популяции. Следующий этап — выбор лаборатории, которая станет основой для воспроизведения. В случайной выборке из d лабораторий выбирается та, которая накопила больше всего наград. Это смещает процесс воспроизведения в сторону более опытных и успешных лабораторий, что вполне соответствует действительности, в которой наибольшим влиянием обладают зрелые лаборатории и учёные. При этом возраст лаборатории никак не влияет на частоту получения наград, так что отбор будет благоприятствовать и тем исследователям, которые быстрее всего добились наибольшего количества наград вне зависимости от возраста.

Впоследствии некоторые черты лаборатории-«родителя» перенимаются новой лабораторией. Такие её параметры, как мощность, качество исследований и доля повторных исследований «мутируют» независимо друг от друга с вероятностями μw, μe и μr соответственно. Во время мутации значение параметра, унаследованного от «родителя», повышается или снижается на величину, которая вычисляется из распределения Гаусса со средним значением, равным нулю, и стандартным отклонением σw, σe или σr для мощности, качества исследования и доли повторных исследований соответственно. Если в ходе мутации величина параметра выходит за пределы допустимого диапазона, она автоматически приобретает максимальное или минимальное значение в рамках этого диапазона.

Безусловно, было бы неразумно предполагать, что «продолжительность жизни» всех учёных одинакова. Многие исследователи исчезают из научных кругов довольно рано, вскоре после получения степени или завершения постдокторантуры. Тем не менее упрощённое предположение об одинаковой ожидаемой продолжительности жизни более чем прекрасно подходит для нашего тезиса. Если факторы, побудившие учёного рано уйти из области, никак не связаны с его публикациями, то они совершенно не влияют на нашу модель — это всего лишь шум, который является неотъемлемой частью случайной природы смерти. С другой стороны, если публикации непосредственно влияют на продвижение чьей-либо научной карьеры, то наша модель становится всего лишь смягчённой демонстрацией мощности отбора по количественному критерию.

После смерти и воспроизведения объём опубликованной литературы следует уменьшить до размеров, удобных для проведения расчётов. Поскольку немногие научные области могут похвастаться более чем миллионом актуальных публикаций (согласно результатам поиска по различным ключевым словам в «Академии Google», в большинстве областей количество работ гораздо меньше), большинство попыток воспроизведения направлено на недавние исследования (например, 90% воспроизведений психологических исследований направлено на работы, которым менее 10 лет [14]), а ограничение доступа к более старым работам делает их воспроизведение практически невозможным [74], мы ограничиваем объём доступных для воспроизведения научных работ до 1 миллиона. Это допущение сделано для того, чтобы уменьшить объёмы вычислений до приемлемого уровня и сделать возможным выявление долгосрочных эволюционных тенденций. В конце каждой эволюционной стадии самые старые из опубликованных работ исключаются до тех пор, пока общее количество работ не станет равным одному миллиону или меньше.

Результаты симуляций

Хотя наша модель гораздо проще любого реального научного сообщества, она всё же остаётся довольно сложной. По этой причине мы представляем фрагменты динамических расчётов в нескольких разделах, чтобы ознакомить читателей с различными факторами.

Естественный отбор «плохой науки»

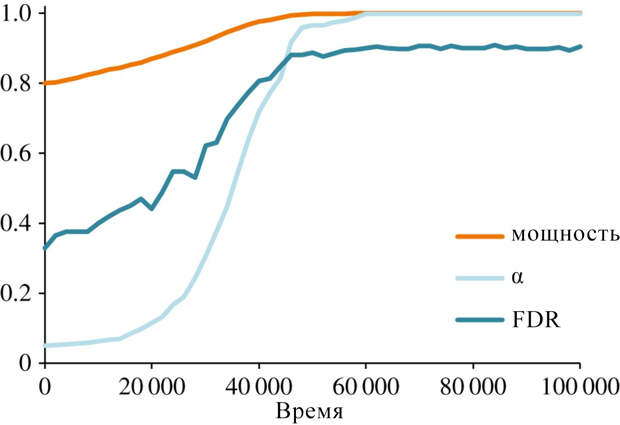

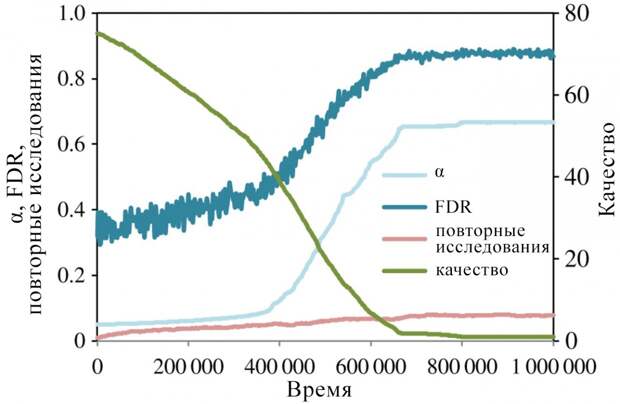

Для начала опустим повторные исследования и сфокусируемся на новых исследованиях (r0 = μr = 0). Рассмотрим эволюцию мощности при постоянном качестве исследований (μe = 0, μw = 0,01). Вместе с увеличением мощности увеличивается доля ложноположительных результатов. Таким образом, рост мощности приводит к увеличению общего числа исследований с положительными результатами, а значит, и числа рассматриваемых для публикации работ. По этой причине в наших симуляциях значения W и α становятся одинаковыми — это означает, что все полученные лабораторией результаты положительны и, следовательно, пригодны для публикации (рисунок 3).

Рисунок 3. Изменение мощности. Кривые изменения средней мощности (W), доли ложноположительных (α) и ошибочных (FDT).

Как следует из рисунка 3, кривые мощности и доли ложноположительных результатов возрастают вплоть до точки слияния при условии отсутствия каких-либо препятствующих сил. Поскольку вероятность публикации находится в прямой зависимости от числа уже опубликованных работ, всё, что увеличивает количество публикаций, повышает и соответствующую вероятность. Вероятность того, что новая гипотеза верна, обозначается постоянным параметром b. Для лаборатории с мощностью W и качеством исследований e вероятность того, что новая гипотеза приведёт к положительному (а значит, и публикуемому) результату, рассчитывается следующим образом:

Pr(+)=Pr(+|T) Pr(T) + Pr(+|F) Pr(F) = bW + (1 − b)W/(1 + (1 − W)e)

Дифференцирование показывает, что эта вероятность представляет собой возрастающую функцию от W. Это означает, что если в основе отбора лежит количественный критерий, мощность будет возрастать вплоть до точки, в которой она столкнётся с противодействующей силой, то есть любыми факторами, ограничивающими диапазон изменений мощности и доли ложноположительных результатов.

Приведённый выше пример неправдоподобен. Исследовательские группы не смогут долгое время безнаказанно подтверждать все гипотезы, не говоря уже о том, что бесконечно увеличивающаяся мощность едва ли окажется выгодной с прагматической точки зрения. Тем не менее существуют научные учреждения, которые поддерживают мощность на относительно высоком уровне, при этом некоторые аспекты этой мощности вполне можно измерить напрямую, например, статистическую мощность. С другой стороны, получить доступ к ложноположительным результатам исследований таких учреждений, как правило, довольно сложно [75, 76].

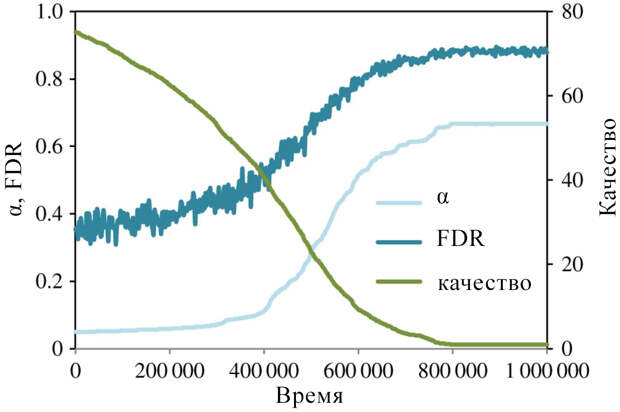

Если мощность может быть измерена и поддерживается на высоком уровне посредством специально предпринимаемых в учреждении мер, частоту публикаций можно увеличить, снизив качество исследований. Мы провели симуляции, в которых мощность имела постоянное значение, однако качество исследований могло меняться (μw = 0, μe = 0,01). В этом случае отбор проходили те лаборатории, которые уделяют меньше внимания качеству исследований и наращивают количество публикаций за счёт увеличения числа ошибочных результатов (рисунок 4). Когда упор делается на количество новых исследований, а отрицательные результаты практически не публикуются, отбор определяют институциональные стимулы, поощряющие большее количество публикаций и приводящие к деградированию научных методик.

Рисунок 4. Изменение качества. Понижение среднего качества исследований соответствует увеличению доли ложноположительных и ошибочных результатов.

Неэффективность повторных исследований

Новые исследования не должны ставиться во главу угла научного процесса. Ошибочные и противоречивые результаты неизбежны даже в случае использования самых тщательных методов. Единственный способ эффективного отделения верных гипотез от ложных заключается в проведении повторных исследований, включая прямое и концептуальное воспроизведение [14, 15]. Могут ли повторные исследования стать препятствием для отбора «плохой науки»? До тех пор, пока они редко публикуются, — едва ли. Представим ситуацию, в которой повторные исследования публикуются часто, а провалившиеся попытки воспроизведения новаторского исследования наносят значительный удар по престижу лаборатории. Смогут ли повторные исследования помешать отбору низкопробных методов в таком случае?

Мы повторили ранее проведённые симуляции, изменив одно из начальных условий: теперь 1% всех исследований — это попытки воспроизведения случайно выбранных опубликованных результатов. Это значение вполне соответствует реальным оценкам доли повторных исследований в области психологии [49]. Также мы приняли допущение, что доля повторных исследований может меняться посредством мутаций и отбора (r0 = 0,01, μw = 0, μr = μe = 0,01). Выбранные для симуляций условия благоприятствовали воспроизведению. Мы отталкивались от предположения, что все попытки воспроизведения публикуются, а их эволюционное преимущество наполовину меньше преимущества новаторского исследования (под преимуществом подразумевается престиж). Кроме того, успешное воспроизведение новаторского исследования повышало ценность опубликованной работы на 10%, а неудачное воспроизведение было равнозначно катастрофе и налагало на неё штраф, в 100 раз превышающий ценность (иными словами, VO+ = 0,1, VO− = −100). Последнее допущение может показаться чрезмерно жёстким, однако опыт показывает, что опровержения приводят к значительному сокращению цитирования предыдущих работ исследователя [77]. Кроме того, существует мнение, что научные учреждения должны поощрять повторные исследования при помощи системы «возврата денег», когда исследователей принуждают выплатить довольно высокий штраф, если результаты их исследований не удалось воспроизвести [78]. В общем и целом, эти допущения благоприятствуют идее о том, что воспроизведение помогает бороться с неверными методами, поскольку выявляет ложноположительные результаты.

По результатам симуляций выяснилось, что средняя доля повторных исследований медленно, но неуклонно выросла до 0,08. Это объясняется тем, что повторные исследования гарантированно получали публикацию, несмотря на то, что их ценность в два раза меньше по сравнению с новыми исследованиями. С другой стороны, увеличение числа повторных исследований не смогло предотвратить отбор низкопробных методов, поскольку снижение качества работ настолько увеличило число ложноположительных результатов, что новые гипотезы начали чаще приносить положительные результаты (рисунок 5). В такой ситуации проведение повторных исследований становится менее выгодным, чем понижение качества исследований и поиск новых гипотез.

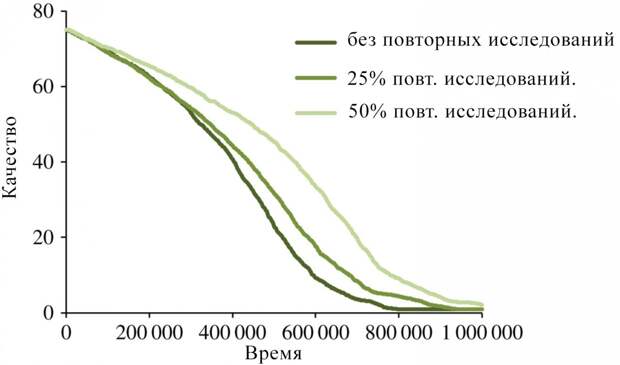

Рисунок 5. Изменение качества исследований и числа повторных исследований.

Поскольку доля повторных исследований увеличивалась довольно медленно по сравнению с темпами снижения качества, мы решили рассмотреть вероятность того, что более высокая доля повторных исследований всё-таки может поддерживать качество работ на высоком уровне — при условии, что такая большая доля в принципе возможна. Чтобы проверить эту гипотезу, мы запустили симуляции, в которых доля повторных исследований не может мутировать (μr = 0) и изначально находится на очень высоком уровне. В результате темпы снижения качества работ замедлились, но даже при максимально возможной доле повторных исследований (50%) предотвратить этот процесс не удалось (рисунок 6). Следует подчеркнуть, что мы не разделяем точку зрения, что жёсткое наказание за исследование, результаты которого воспроизвести не удалось, приносит пользу, поскольку даже самые качественные исследования иногда не удаётся повторить. Мы, скорее, хотим обратить внимание на то, что даже при наличии таких способов наказания институциональные стимулы к увеличению количества публикаций будут по-прежнему способствовать отбору низкопробных методов.

Рисунок 6. Изменение общего качества исследований, когда доля повторных исследований составляет 0, 25, 50%.

Почему повторных исследований недостаточно?

Повторные исследования не могут сдержать естественный отбор «плохой науки», потому что самые продуктивные лаборатории всегда будут идти по пути наименьшего сопротивления. Воспроизведение исследований может помочь наказать некоторые лаборатории с низкопробными методами, однако до тех пор, пока все опубликованные исследования не были повторены несколько раз (идеальный, но недостижимый сценарий), всегда будут оставаться исследователи, избежавшие наказания. Современное научное сообщество характеризуется ограниченными карьерными возможностями и тесным сотрудничеством, в связи с чем высокое положение автора в научной иерархии может автоматически делать его публикации авторитетнее самых достойных работ других исследователей [37, 38, 79].

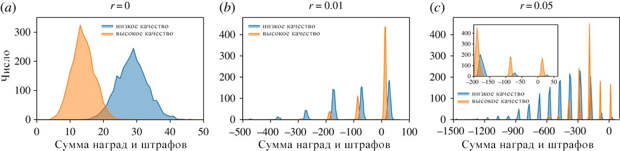

Предложенная нами эволюционная модель не может дать чёткого представления о взаимосвязи между воспроизведением исследований, их качеством и вероятностью отбора, поскольку эти параметры переплетаются между собой самым запутанным образом. В связи с этим мы захотели выяснить, почему самыми успешными оказываются те лаборатории, которые проводят исследования не очень тщательно, даже если это чревато значительными потенциальными расходами из-за суровых штрафов за невоспроизводимые результаты. Для этого мы создали упрощённую версию модели без эволюции: мощность имела постоянное значение 0,8, а все лаборатории делились на две группы с высоким (H) и низким (L) качеством исследований. Лаборатории из первой группы имели качество eH = 0,75 с долей ложноположительных результатов α = 0,05 и частотой исследований h = 0,625. Лаборатории из второй группы имели качество eL = 0,15 с долей ложноположительных результатов α = 0,2 и частотой исследований h = 0,765. Лаборатории с высоким качеством исследований составляли 50% от общего числа. Как и в оригинальной модели, лаборатории проводили исследования и предоставляли полученные результаты на рассмотрение. Базовый набор публикаций был получен на основании 10 временных отрезков, при этом по условиям симуляции повторные исследования в этот период не проводились. Также были симулированы дополнительные 100 отрезков, эквивалентные ожидаемой продолжительности жизни лаборатории в эволюционной модели. В течение этого времени любое исследование могло быть проведено повторно с вероятностью r. Эта упрощённая модель позволяет изучить распределение наград за успешные публикации и штрафов за неподтвердившиеся в повторных исследованиях результаты, а также непосредственно сравнить лаборатории с высоким и низким качеством исследований.

На рисунке 7 показаны три распределения наград и штрафов в зависимости от доли повторных исследований. В случае отсутствия повторных исследований лаборатории с низкопробными методами обладают неоспоримым преимуществом. По мере увеличения этой доли средняя величина вознаграждения лабораторий с высоким качеством исследований начинает превышать аналогичный параметр для лабораторий с низким качеством исследований, поскольку на первые реже налагают штрафы. Тем не менее по теории вероятностей некоторые лаборатории могут не получать ложноположительных результатов в принципе или же избегать наказания за это, и среди них преимущество получают те лаборатории, которые используют низкопробные методы. Если самые авторитетные лаборатории обладают несоразмерным влиянием на выдачу грантов и успешность студентов, это небольшое преимущество ведёт к масштабным последствиям, когда происходит постоянный отбор низкопробных методов и растёт количество ошибочных результатов, что чётко прослеживается в нашей эволюционной модели.

Рисунок 7 (нажмите на изображение, чтобы увеличить). Награды и штрафы лабораторий из неэволюционной модели. На каждом графике показаны распределения суммы наград и штрафов для лабораторий с низким и высоким качеством проведения исследований после 110 временных отрезков, на 100 из которых проводились повторные исследования. Общее число для каждой награды или штрафа представляет собой сумму 50 симуляций для каждого условия. График (с) включает вложенный график на основании тех же данных, но с более узким диапазоном штрафов и наград. Наказание за результаты нового исследования, которые не удалось воспроизвести, на порядок превышает выгоду от публикации, как следует из отдельных участков резкого возрастания графиков (b) и (с).

Комментарий

Стимулы — движущая сила культурной эволюции. Побуждение к увеличению объёма публикаций может привести к естественному отбору низкопробных методов в научном сообществе. В данной работе мы привели экспериментальные данные, которые доказывают процесс отбора, а также разработали его общую модель. Если мы стремимся к повышению уровня научной культуры, то следует обращать внимание не только на поведение отдельных учёных, но и на те социальные силы, которые делают возможным и поощряют подобное поведение [1, 80]. Мы не первые, кто указывает на необходимость изменения стимулов к продвижению научной карьеры [68, 69, 81-89], однако именно в нашей работе впервые была описана логика эволюционного процесса научных методов, а также показаны последствия сложившейся на данный момент ситуации: если ничего не изменится, наука неизбежно деградирует.

Если схема стимулирования направлена на увеличение числа публикаций, она будет способствовать отбору методов, которые позволяют добиться наибольшей продуктивности — при условии отсутствия противодействующих факторов. Это, в свою очередь, приводит к естественному отбору некачественных методов и чрезвычайно высокой доле ошибочных исследований. Хотя в центре внимания нашей работы были именно ошибочные результаты, это не единственное негативное последствие подобной схемы стимулирования. Тщательное исследование сложного вопроса может потребовать нескольких лет интенсивной работы, прежде чем будут получены подходящие для публикации непротиворечивые результаты. Если сложившаяся в научном сообществе обстановка благоприятствует самым продуктивным исследователям с менее тщательным подходом к работе, то те учёные, которые заинтересованы в изучении сложных проблем, наверняка останутся без работы. Дискриминация по продуктивности на рынке труда наверняка принёсет более масштабные негативные последствия для научного сообщества в целом.

«Хорошая наука» — это в каком-то смысле общественное благо, за которым скрывается конфликт между кооперативными и одиночными исследованиями. Кооперативные исследования позволяют получать полезные результаты (то есть качественные исследования) за счёт блага отдельных участников (то есть уменьшение «преимущества» в плане карьерного продвижения). Тому, кто знаком с теорией игр в решении социальных дилемм, может показаться, что постоянного вклада в общественное благо — то есть выбора в пользу кооперативных, а не одиночных исследований — можно добиться при помощи таких общеизвестных механизмов, как взаимная выгода, отслеживание и наказание [90]. Однако если рассуждать логически, выгода, которую получают участники кооперации и одиночные исследователи, должна измеряться в одних и тех же единицах — единицах эволюционного преимущества. Нельзя отрицать, что коалиции учёных, тщательно проводящих исследования, достигают лучших результатов по сравнению с индивидуальными исследователями, которые работают в изоляции и используют менее качественную методику. В связи с этим неудивительно, что в последнее время во многих научных областях количество кооперативных исследований увеличилось [30, 31]. Однако популярность кооперации также может быть ответом на стимулы к увеличению объёма публикаций, поскольку маленький вклад во множество проектов обеспечивает лучшую продуктивность, чем большой вклад в малое количество проектов. Таким образом, кооперация совершает вклад в общественное благо в плане качественных исследований и пополнения знаний, однако не даёт преимущества в отношении культурной эволюции научных методов. По этой причине обычных решений, инициируемых «снизу», недостаточно. Для того чтобы наука развивалась, необходимо поменять отношение к оценке работы учёных — это ключевая мысль, которую мы хотели донести в данной работе.

Добиться изменений на институциональном уровне довольно трудно, поскольку для этого необходима широкомасштабная координация, которая зачастую довольно дорого обходится своим первым сторонникам [91, 92]. И всё же сделать этот шаг необходимо, если мы хотим сохранить чистоту науки. В связи с этим стоит подумать над реформами, которые следовало бы провести. На первый взгляд может показаться, что журналы и рецензенты должны выдвигать более жёсткие требования к публикации. Несмотря на то, что это может помочь сократить объём недобросовестных исследований в печати, возможность их появления будет оставаться до тех пор, пока успешность учёного ассоциируется с количеством его публикаций.

Предложение о наказании учёных за результаты исследований, которые не удалось воспроизвести, кажется не очень эффективной мерой предотвращения эволюции «плохой науки». Многие важные результаты исследований изначально кажутся маловероятными, поэтому провести чистые эксперименты затруднительно. Кроме того, полностью избавиться от ложноположительных результатов, скорее всего, не получится [86], не говоря уже о том, что сами повторные исследования могут дать ложноотрицательные результаты. Не следует также забывать, что некоторые научные исследования воспроизвести невозможно: к примеру, клинические исследования с большой выборкой или исследования, связанные с данными за прошедшие периоды. Представление о повторных исследованиях как средстве спасения всей науки основано на предпочтении одних научных областей другим. Таким образом, не стоит слишком жёстко наказывать учёных, результаты исследований которых не подтверждаются при воспроизведении.

Более радикальное предложение заключается в полном изменении ландшафта отбора, критериев определения успеха и стимулов к нему. Осуществить эту идею на практике наверняка будет довольно сложно. Следует учитывать, что у спонсоров научных исследований и практикующих исследователей могут быть разные мотивы [82]. Например, спонсоры могут ожидать «отдачи» в виде опубликованных работ, что будет подталкивать учёных проводить исследования так, чтобы максимально увеличить продуктивность, даже если при карьерном продвижении и получении работы учитывается не количество, а качество публикаций. Ещё одна сложность связана с ограниченностью времени и когнитивных ресурсов, которые необходимы для оценки работы учёного. Оценивать профессиональные качества исследователей довольно сложно, поскольку «хороший учёный» — это очень ёмкое понятие, превращающее процесс оценивания в крупномасштабную проблему оптимизации. Такие количественные критерии, как число публикаций и импакт-фактор, отчасти используются потому, что они просты и позволяют проводить чёткие и непротиворечивые сравнения. В то же время количественными показателями легко начать злоупотреблять. На самом деле ландшафт отбора в научном сообществе зависит от многих показателей. Хотя при построении карьеры без публикаций не обойтись, существуют и другие способы достижения успеха, которые никак не связаны с длиной послужного списка в резюме. Мы должны оказывать поддержку всем институтам, которые продвигают эти альтернативные способы, стимулируют качество исследований и защищают учёных от социального и психологического давления по поводу количества публикаций.

Мы полагаем, что наша интерпретация математической модели вполне обоснована, если соблюдается хотя бы одно из двух условий: (i) отрицательные результаты публикуются реже положительных; (ii) понижение качества исследований увеличивает продуктивность лаборатории. Во избежание предвзятости подтверждения мы пытались отклониться от нашей гипотезы, подставив в параметры модели величины, которые показались нам наиболее рациональными. К примеру, мы проводили симуляции, задав крайне высокое число повторных исследований и очень жёсткое наказание за результаты, которые не удалось воспроизвести. Однако мы не проводили полный сенситивный анализ модели. В связи с этим мы напоминаем, что исходный код нашей модели можно найти среди приложенных к данной работе электронных материалов, так что все заинтересованные читатели могут с ним ознакомиться, провести собственную проверку и продолжить наш анализ.

В нашей модели результаты всех новых исследований считаются равнозначными, однако на самом деле это, конечно же, не так. Публикации в самых престижных журналах получают наибольшее внимание и чаще всего цитируются [94]. Как показывает опыт, многие учёные — от недавних выпускников до полноценных профессоров — судят о том, подходит ли кандидат на должность, опираясь на то, были ли опубликованы его работы в престижных журналах. Такой параметр, как престиж журнала, немного изменил бы нашу модель, однако суть её осталась бы прежней, поскольку престиж побуждает учёных публиковаться в данном журнале любой ценой. Большим изменением в нашей модели могло бы стать выделение научных работ с крайне неправдоподобными результатами, которые, скорее всего, ложны. Исследования показывают, что статистическая мощность публикаций в престижных журналах (с высоким импакт-фактором) и менее популярных изданиях примерно одинакова [84], при этом частота опровержений находится в прямой зависимости от величины импакт-фактора [95]. Хотя отчасти это объясняется тем, что престижные журналы имеют большую аудиторию, хорошо известно, что издания с высоким импакт-фактором часто отказывают в публикации компетентным учёным, посчитав их исследования недостаточно новаторскими.

Представленная в данной работе модель даёт пессимистичную картину научного сообщества. Будем честны: большинство учёных в курсе сложностей, связанных с оценкой профессионализма, и многие комитеты, выдающие гранты или принимающие новых сотрудников на работу, оценивают исследователей по качеству, а не количеству и месту публикации их исследований. Более того, мы верим в то, что главным стимулом к работе для большинства учёных остаётся искреннее желание раскрыть правду о мире. Было бы слишком цинично полагать, что мотивы учёных связаны только с внешними стимулами и что исследователи всегда стараются соответствовать ожиданиям Человека экономического. Ключевая особенность нашей эволюционной модели заключается в допущении, что отдельные субъекты не имеют отрицательных намерений и сознательно не меняют свои методы в качестве реакции на стимулы. Вернее было бы сказать, что отбор на институциональном уровне благоприятствует исследовательским группам, которые по каким-либо причинам используют методы, позволяющие увеличить продуктивность работы. Любые намеренные социальные действия, такие как копирование методов с целью достижения успеха, только ускоряют общее направление эволюции.

Несмотря на поощрение продуктивности, многие учёные всё же тщательно подходят к методике и проверяют полученные данные на практике или в ходе повторных исследований. «Хорошая наука» никуда не исчезла. Это связано с тем, что число публикаций почти никогда не является единственным условием успеха в научной карьере — учитываются также важность изучаемой темы, качество работы и оценка рецензентов. Степень влияния каждого из этих факторов различается в зависимости от дисциплины. В некоторых научных областях могут поощряться высококачественные методы исследования, особенно если соответствующие принципы закреплены на институциональном уровне в виде норм. В таких случаях для поддержания общего высокого уровня исследований достаточно будет просто нивелировать отрицательное влияние стимулов к увеличению продуктивности. В обратной ситуации, когда успех определяется объёмом публикаций или любыми другими количественными критериями, все, кто высоко ценит научную культуру, должны быть настороже. Если нам не безразлично будущее науки, нужно пристально следить за тем, в какую сторону склонятся весы в каждой научной области.

Когда при оценке и вознаграждении учёных используются количественные критерии, ими легко начать злоупотреблять, поскольку оценивать исследования, опираясь на их количество, проще, чем пытаться улучшить их качество напрямую. Официальные руководства по оценке исследований могут дать приблизительное представление о том, на что учёные тратят свою энергию, и таким образом олицетворяют ту науку, с которой нужно покончить. По-настоящему эффективное решение проблемы, скорее всего, будет включать в себя множество различных мер, поскольку создать систему, поощряющую только качество исследований, довольно тяжело5. Улучшения проявятся не сразу, а тщательная проверка исследований потребует больших затрат времени от учёных, которые и так загружены работой. В условиях жёсткой конкуренции за работу и гранты рецензентам также потребуются способы выхода на исследователей. Кроме того, понятия об отличном качестве у всех учёных свои. Количество исследований или публикаций, а также импакт-фактор журнала — это простые и объективные показатели, которые позволяют рецензентам значительно сократить время и силы и не оставляют места для двусмысленности. К сожалению, долгосрочные затраты на такие простые количественные методы оценки довольно велики. Если мы действительно хотим повысить значимость и качество научных исследований, следует позаботиться о том, чтобы качественные методы исследований поощрялись на институциональном уровне.

Перевела Яна Шутрова. Редактура — Надежда Верещагина. Иллюстрации Анастасии Икусовой, адаптация графиков — Радмир Абильев.

Список цитируемой литературы смотрите в первоисточнике.

Пол Смальдино1 и Ричард Мак-Элрес2 (Paul E. Smaldino and Richard McElreath). «The natural selection of bad science». Royal society open science. Published 21 September 2016. DOI: 10.1098/rsos.160384.

1 Когнитивистика и теория информации, Калифорнийский университет, Мерсед, CA 95343, США

2 Отделение человеческого поведения, экологии и культуры, Институт эволюционной антропологии общества Макса Планка, Лейпциг, Германия

Свежие комментарии